Общие вопросы парсинга

Лучшие инструменты для веб-парсинга

Вы планируете начать новый проект по веб-парсингу и ищете лучшие инструменты для веб-парсинга? Заходите прямо сейчас и откройте для себя лучшие инструменты, в том числе инструменты, предназначенные для не-кодеров. Хотя вы можете разработать свой собственный инструмент для веб-парсинга с нуля для своих задач по веб-парсингу, разумно сказать, что это будет не только пустой тратой вашего времени, но и всех других ресурсов, которые вы вложите в это, если у вас нет весомых причин. Вместо того, чтобы идти по этому пути, вам нужно поискать на рынке уже существующие решения, которые можно использовать. Если речь идет об инструментах для веб-парсинга, то вы должны знать, что на рынке существует множество таких инструментов. Однако не все они одинаковы. Некоторые из них работают лучше, чем другие; некоторые более популярны, чем другие; кривая обучения каждого из инструментов также отличается. Как и поддержка платформы и языка программирования, а также то, для чего они предназначены. Однако мы все же можем прийти к соглашению относительно лучших инструментов для веб-парсинга на рынке, и каждый из них будет рассмотрен ниже. В списке представлены инструменты, разработанные для тех, кто владеет навыками программирования, и для тех, кто не является кодером.

СФЕРА РАЗВЛЕЧЕНИЙ

ИСКУССТВО И КУЛЬТУРА

ОБРАБАТЫВАЮЩИЕ ПРОИЗВОДСТВА

База всех компаний в категории: ОКВЭД 33.11 — РЕМОНТ МЕТАЛЛОИЗДЕЛИЙ

АРЕНДА НЕДВИЖИМОСТИ

РЕМОНТНАЯ ДЕЯТЕЛЬНОСТЬ

Инструменты веб-парсинга для кодеров

Изначально веб-парсинг был задачей кодеров, поскольку перед тем, как скреативить сайт, необходимо написать код, и поэтому на рынке существует большое количество инструментов, созданных специально для кодеров. Инструменты веб-парсинга для кодеров представлены в виде библиотек и фреймворков, которые разработчик включает в свой код, чтобы получить требуемое поведение от своего веб-парсинга.

Библиотеки для веб-парсинга на языке Python

Python является самым популярным языком программирования для создания веб-парсингов благодаря простому синтаксису, кривой обучения и количеству доступных библиотек, облегчающих работу разработчиков. Некоторые из библиотек и фреймворков для веб-парсинга, доступных разработчикам на Python, рассмотрены ниже.

Scrapy

Scrapy — это фреймворк для веб-парсинга, написанный на языке Python для разработчиков Python. Scrapy — это полноценный фреймворк, и поэтому он поставляется со всем необходимым для веб-парсинга, включая модуль для отправки HTTP-запросов и анализа данных из загруженной HTML-страницы. Он имеет открытый исходный код и бесплатен для использования. Scraping также предоставляет возможность сохранять данные. Однако Scrapy не поддерживает JavaScript и поэтому требует помощи другой библиотеки. Для этого можно использовать Splash или популярный инструмент автоматизации браузера Selenium.

PySpider

PySpider — это еще один инструмент для веб-парсинга, который можно использовать для написания скриптов на языке Python. В отличие от Scrapy, он может обрабатывать JavaScript и поэтому не требует использования Selenium. Однако он менее развит, чем Scrapy, поскольку Scrapy существует с 2008 года и имеет лучшую документацию и сообщество пользователей. Это не делает PySpider неполноценным. На самом деле, PySpider обладает некоторыми непревзойденными возможностями, такими как редактор сценариев с веб-интерфейсом.

Requests

Requests — это библиотека HTTP, которая упрощает отправку HTTP-запросов. Она построена на основе urllib. Это надежный инструмент, с помощью которого можно создавать более надежные веб-парсеры. Она проста в использовании и требует меньше строк кода. Очень важен тот факт, что он может помочь вам обрабатывать куки и сессии, а также аутентификацию и автоматическое объединение соединений, среди прочего. Он бесплатен в использовании, и разработчики Python используют его для загрузки страниц перед использованием парсера для разбора необходимых данных.

BeautifulSoup

BeautifulSoup упрощает процесс разбора данных с веб-страниц. Он устанавливается поверх парсера HTML или XML и предоставляет вам Python-способы доступа к данным. BeautifulSoup стал одним из самых важных инструментов веб-парсинга на рынке благодаря простоте парсинга, который он обеспечивает. Фактически, большинство учебников по веб-парсингу используют BeautifulSoup для обучения новичков написанию веб-парсеров. При использовании вместе с Requests для отправки HTTP-запросов, веб-парсеры становятся проще в разработке — намного проще, чем при использовании Scrapy или PySpider.

Selenium

Scrapy, Requests и BeautifulSoup не помогут вам, если сайт Ajaxified — то есть зависит от AJAX-запросов для загрузки определенных частей страницы через JavaScript. Если вы обращаетесь к такой странице, вам необходимо использовать Selenium, который является инструментом автоматизации веб-браузера. Его можно использовать для автоматизации безголовых браузеров, таких как безголовые Chrome и Firefox. Более старые версии может автоматизировать PhantomJS. Node.JS становится популярной платформой для веб-парсеров, благодаря популярности JavaScript. Он также имеет хорошее количество инструментов для веб-парсинга, но не так много, как Python. Ниже рассматриваются два наиболее популярных инструмента для среды исполнения Node.JS.

Cheerio

Cheerio для Node.JS — это то же самое, что BeautifulSoup для Python. Это библиотека синтаксического анализа, которая разбирает разметку и предоставляет API для обхода и манипулирования содержимым веб-страницы. У нее нет возможности рендеринга JavaScript, и для этого вам понадобится безголовый браузер — ее единственная задача — предоставить вам jQuery-подобный API для парсинга данных с веб-страниц. Он гибкий, быстрый и довольно простой в использовании.

Puppeteer

Puppeteer — один из лучших инструментов для веб-парсинга, который вы можете использовать как разработчик JavaScript. Он представляет собой инструмент автоматизации браузера и предоставляет высокоуровневый API для управления Chrome. Puppeteer был разработан компанией Google и предназначен только для браузера Chrome и других браузеров Chromium. В отличие от Selenium, который является кроссплатформенным, Puppeteer предназначен только для среды Node. Кодеры, которые не имеют опыта использования прокси для парсинга веб-сайтов, или те, кто не хочет беспокоиться об управлении прокси и решении капчи, просто используют API для веб-парсинга, которые либо помогают им извлекать данные с веб-сайтов, либо загружают всю веб-страницу для парсинга. Лучшие API для веб-парсинга рассмотрены ниже.

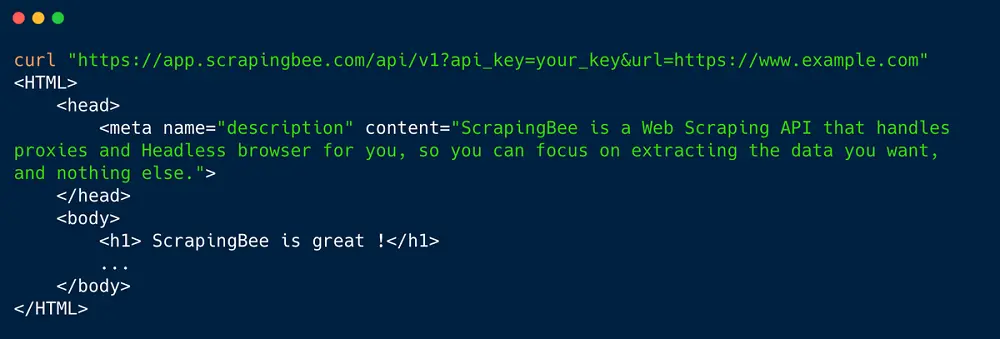

ScrapingBee

- Размер прокси-пула: Не разглашается

- Поддерживает геотаргетинг: Да

- Стоимость: от $29 за 250 000 кредитов API

- Бесплатные испытания: 1 000 вызовов API

- Специальные функции: Работа с браузером для рендеринга JavaScript

ScrapingBee — это API для веб-парсинга, который поможет вам загружать веб-страницы. С ScrapingBee вам не придется думать о блоках, а о разборе данных из загруженной веб-страницы, возвращенной в качестве ответа ScrapingBee. ScrapingBee прост в использовании и требует всего лишь вызова API. ScrapingBee использует большой пул IP-адресов для маршрутизации ваших запросов и предотвращения их запрета. Он также помогает в работе с безголовым Chrome, что не так просто, особенно при масштабировании сетки безголового Chrome.

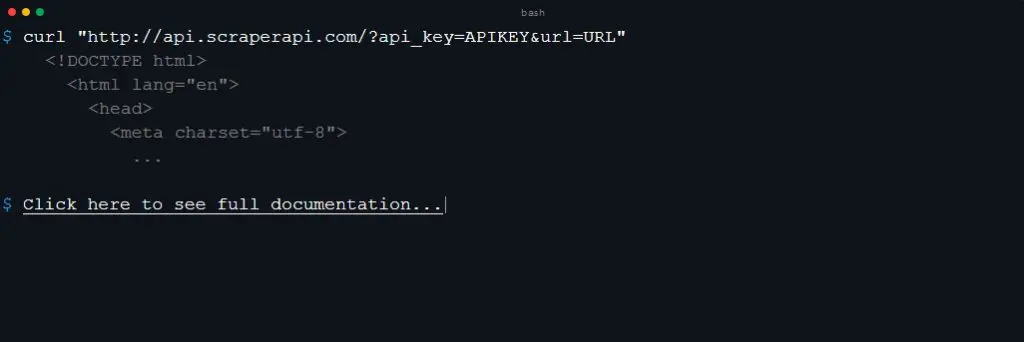

Scraper API

- Размер прокси-пула: более 40 миллионов

- Поддержка геотаргетинга: зависит от выбранного плана

- Стоимость: от $29 за 250 000 вызовов API

- Бесплатные пробные версии: 1 000 вызовов API

- Специальные функции: Решает Captcha и обрабатывает браузеры

Ежемесячно обрабатывая более 5 миллиардов API-запросов, Scraper API является силой, с которой приходится считаться на рынке API для веб-парсинга. Его система достаточно функциональна и может помочь вам справиться с большим количеством задач, включая ротацию IP-адресов с помощью собственного прокси-пула с более чем 40 миллионами IP-адресов. Помимо ротации IP-адресов, Scraper API также работает с безголовыми браузерами и поможет вам избежать непосредственной работы с каптчами. Этот API для веб-парсинга быстрый и надежный, в списке его клиентов большое количество компаний из списка Fortune 500. Цена также является разумной.

Apify

- Ценообразование: От $49 в месяц

- Бесплатные пробные версии: Полнофункциональный бесплатный аккаунт с кредитом $5 каждый месяц

- Формат вывода данных: JSON, CSV, Excel, XML, HTML, RSS

- Поддерживаемые ОС: Облако, Windows, Mac, Linux

Платформа Apify для веб-парсинга и автоматизации предназначена для создания API для любого веб-сайта и извлечения из него структурированных данных. Apify включает собственный интеллектуальный прокси-сервис для повышения надежности парсинга на сайтах с развитой системой защиты от парсинга. Apify предлагает сотни готовых парсеров для популярных сайтов, но недорогие индивидуальные решения можно легко и быстро заказать. Все парсеры Apify могут быть настроены, запланированы и запущены любым человеком без навыков кодирования, но платформа также достаточно мощная, чтобы быть идеальной для опытных разработчиков.

Zenscrape

- Размер прокси-пула: более 30 миллионов

- Поддерживает геотаргетинг: Да, ограниченно

- Стоимость: От $8,99 за 50 000 запросов

- Бесплатные испытания: 1 000 запросов

- Специальные функции: ручки без головки Chrome

Zenscrape поможет вам извлечь данные с веб-сайтов без лишних хлопот по доступной цене — у них даже есть бесплатный пробный план, как и у других, чтобы вы могли протестировать их услуги, прежде чем брать на себя денежные обязательства. Zenscrape загрузит для вас страницу, как она выглядит для обычных пользователей, и может обрабатывать гео-таргетинг контента в зависимости от выбранного вами плана. Очень важным является тот факт, что он отлично обрабатывает рендеринг JavaScript, поскольку все запросы выполняются в безголовом Chrome. Он даже поддерживает популярные JavaScript-фреймворки.

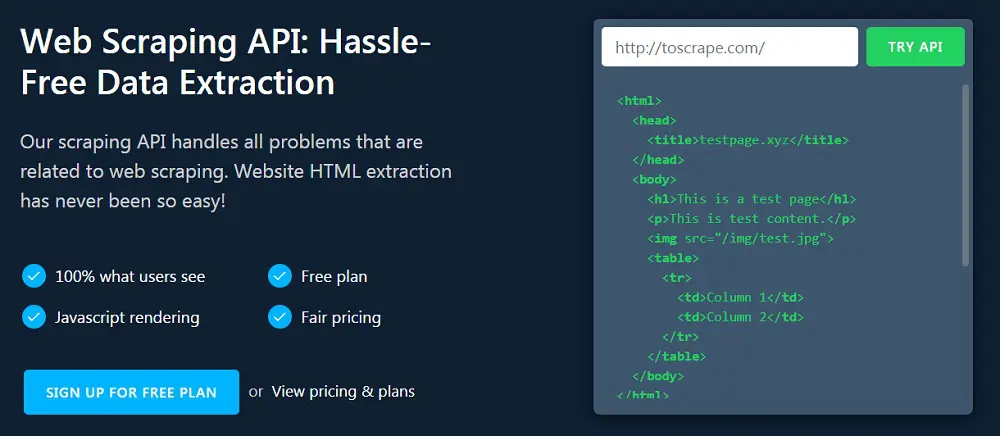

ScrapingAnt

- Размер прокси-пула: Не раскрыто

- Поддерживает геотаргетинг: Да

- Стоимость: от $9 за 5 000 запросов

- Бесплатные пробные версии: да

- Специальные функции: Решает Captcha и отображает JavaScript

Парсинг сайтов со строгой системой защиты от спама — сложная задача, поскольку вам придется иметь дело с большим количеством препятствий. ScrapingAnt поможет вам справиться со всеми препятствиями и получить необходимые данные без особых усилий. Он обрабатывает выполнение JavaScript с помощью безголового Chrome, работает с прокси-серверами и помогает избежать капчи. ScrapingAnt также обрабатывает пользовательские cookies и предварительную обработку вывода. Он имеет дружественные цены, поскольку вы можете начать использовать его API для веб-парсинга всего за 9 долларов.

AutoExtract API

- Размер прокси-пула: Не раскрыто

- Поддержка геотаргетинга: да, но ограниченно

- Стоимость: $60 за 100 000 запросов

- Бесплатные испытания: 10 000 запросов в течение 14 дней

- Специальные функции: Извлечение определенных данных с веб-сайтов

AutoExtract API — это один из лучших API для веб-парсинга, которые вы можете найти на рынке. Он был разработан компанией Scrapinghub, создателем Crawlera, прокси API, и ведущим сопровождающим Scrapy, популярного фреймворка для парсинга для программистов на Python. AutoExtract API — это инструмент извлечения данных на основе API, который поможет вам извлекать конкретные данные с веб-сайтов без предварительного знакомства с ними — то есть, не требуется никакого кода для конкретного сайта. AutoExtract API поддерживает извлечение новостей и блогов, продуктов электронной коммерции, объявлений о вакансиях, данных о транспортных средствах и др.

Лучшие инструменты для веб-парсинга для не кодеров

В прошлом веб-парсинг требовал написания кодов. Это уже не так, поскольку были разработаны некоторые инструменты для веб-парсинг, специально предназначенные для тех, кто не является кодером. С помощью этих инструментов вам не нужно писать коды, чтобы парсить необходимые данные из Интернета. Эти инструменты могут быть в виде устанавливаемого программного обеспечения, облачного решения или расширения для браузера.

Программное обеспечение для веб-парсинга

На рынке существует множество программ, которые можно использовать для поиска любых данных в Интернете без знания кода. Ниже приведены 5 лучших вариантов, представленных на рынке в настоящее время.

Octoparse

- Ценообразование: От 75 долларов в месяц

- Бесплатные пробные версии: 14 дней бесплатной пробной версии с ограничениями

- Формат вывода данных: CSV, Excel, JSON, MySQL, SQLServer

- Поддерживаемые ОС: Windows

Octoparse делает веб-парсинг простым для всех. С помощью Octoparse вы можете быстро превратить полный веб-сайт в структурированную электронную таблицу всего за несколько кликов. Octoparse не требует навыков кодирования, от вас требуются только точки и клики, и вы получите необходимые данные. Octoparse может парсить данные со всех видов веб-сайтов, включая Ajaxified сайты со строгими методами защиты от парсинга. Он использует ротацию IP-адресов, чтобы скрыть ваш IP-отпечаток. Помимо устанавливаемого программного обеспечения, у них есть облачное решение, и вы даже можете воспользоваться 14-дневной бесплатной пробной версией.

Helium Scraper

- Ценообразование: Единовременная покупка — от $99 с 3-месячными обновлениями

- Бесплатные пробные версии: Полнофункциональная 10-дневная пробная версия

- Формат вывода данных: CSV, Excel

- Поддерживаемые ОС: Windows

Helium Scraper — это еще одно программное обеспечение, которое можно использовать для парсинга веб-сайтов, не являясь кодером. Вы можете собирать сложные данные, определяя свои собственные действия — для кодеров; они также могут запускать пользовательские файлы JavaScript. Благодаря простому рабочему процессу, использовать Helium Scraper не только легко, но и быстро, поскольку он имеет простой, интуитивно понятный интерфейс. Helium Scraper также является одной из программ для веб-парсинга с хорошим количеством функций, включая планирование парсинга, ротацию прокси, работу с текстом и вызовы API, среди прочих функций.

ParseHub

- Ценообразование: Настольная версия бесплатна

- Формат вывода данных: JSON, Excel

- Поддерживаемые ОС: Windows, Mac, Linux

ParseHub поставляется в двух версиях — бесплатное настольное приложение и платное облачное решение для парсинга, которое имеет дополнительные функции и не требует установки для использования. Настольное приложение ParseHub позволяет легко спарсить любой сайт, даже без навыков кодирования. Это связано с тем, что программа предоставляет интерфейс «наведи и щелкни», который предназначен для обучения программы работе с данными, которые необходимо спарсить. Оно отлично работает с современными веб-сайтами и позволяет загружать парсинговые данные в популярных форматах файлов.

ScrapeStorm

- Ценообразование: От $49,99 в месяц

- Бесплатные пробные версии: Стартовый план бесплатен, но имеет свои ограничения

- Формат вывода данных: TXT, CSV, Excel, JSON, MySQL, Google Sheets и т.д.

- Поддерживаемые ОС: Windows, Mac, Linux

ScrapeStorm отличается от других настольных приложений, описанных выше, тем, что в нем используется интерфейс «наведи и щелкни», и он не может автоматически определить необходимые данные. ScrapeStorm использует искусственный интеллект для интеллектуального определения конкретных точек данных на веб-страницах. ScrapeStorm быстр, надежен и прост в использовании. Что касается поддержки ОС, ScrapeStorm обеспечивает поддержку Windows, Mac и Linux. Он поддерживает несколько методов экспорта данных и позволяет выполнять поиск на уровне предприятия. Интересно, что он разработан бывшей командой разработчиков краулеров Google.

WebHarvy

- Ценообразование: Единовременная покупка — от $139 за одну лицензию

- Бесплатные пробные версии: 14 дней бесплатной пробной версии с ограничениями

- Формат вывода данных: CSV, Excel, XML, JSON, MySQL

- Поддерживаемые ОС: Windows

WebHarvy — это еще одна программа для парсинга, которую вы можете установить на свой компьютер, чтобы помочь вам в работе со скрапбукингом и извлечением данных с веб-страниц. Это программное обеспечение позволяет выполнять парсинг, написав всего одну строчку кода, и дает вам возможность сохранять спарсенные данные либо в файле, либо в базе данных. Это мощный визуальный инструмент, который можно использовать для парсинга всех видов данных с веб-страниц, таких как электронные письма, ссылки, изображения и даже полные HTML-файлы. Он поставляется с интеллектуальным обнаружением шаблонов и позволяет просматривать несколько страниц.

Расширения для веб-парсеров

Среда браузера становится популярной среди веб-парсеров, и существует большое количество инструментов веб-парсера, которые можно установить в качестве расширений и дополнений к браузеру, чтобы помочь вам парсить данные с веб-сайтов. Некоторые из них рассмотрены ниже.

Webscraper.io

- Ценообразование: Бесплатно

- Бесплатные пробные версии: Версия для Chrome полностью бесплатна

- Формат вывода данных: CSV

Расширение для браузера Webscraper.io (Chrome и Firefox) представляет собой один из лучших инструментов веб-парсинга, с помощью которого можно легко извлекать данные из веб-страниц. Его установили более 250 тысяч пользователей, и они считают его невероятно полезным. Это расширение браузера не требует от вас знания кода, так как оно использует интерфейс «наведи и щелкни». Интересно, что его можно использовать для сканирования даже самых современных веб-сайтов с большим количеством действий, запускаемых JavaScript.

Data Miner

- Ценообразование: От $19,99 в месяц

- Бесплатные пробные версии: 500 страниц в месяц

- Формат вывода данных: CSV, Excel

Расширение Data Miner доступно только для Google Chrome и браузера Microsoft Edge. С его помощью можно парсить данные со страниц и сохранять их в CSV или Excel-таблице. В отличие от бесплатного расширения Webscraper.io, расширение Data Miner бесплатно только для первых 500 страниц, спарсеных за месяц — после этого для его использования необходимо подписаться на платный тарифный план. С этим расширением вы можете парсить любые страницы, не задумываясь о блоках — и ваши данные останутся конфиденциальными.

Scraper

- Ценообразование: Полностью бесплатно

- Бесплатные испытания: Бесплатно

- Формат вывода данных: CSV, Excel TXT

Scraper — это расширение Chrome, вероятно, разработанное и управляемое одним разработчиком — у него даже нет собственного веб-сайта, как у других вышеперечисленных. Scraper не настолько продвинут, как остальные расширения для браузера, описанные выше — однако он полностью бесплатный. Основная проблема, связанная со Scraper, заключается в том, что он требует от своих пользователей знания XPath, поскольку именно его вы будете использовать. Из-за этого он не подходит для новичков.

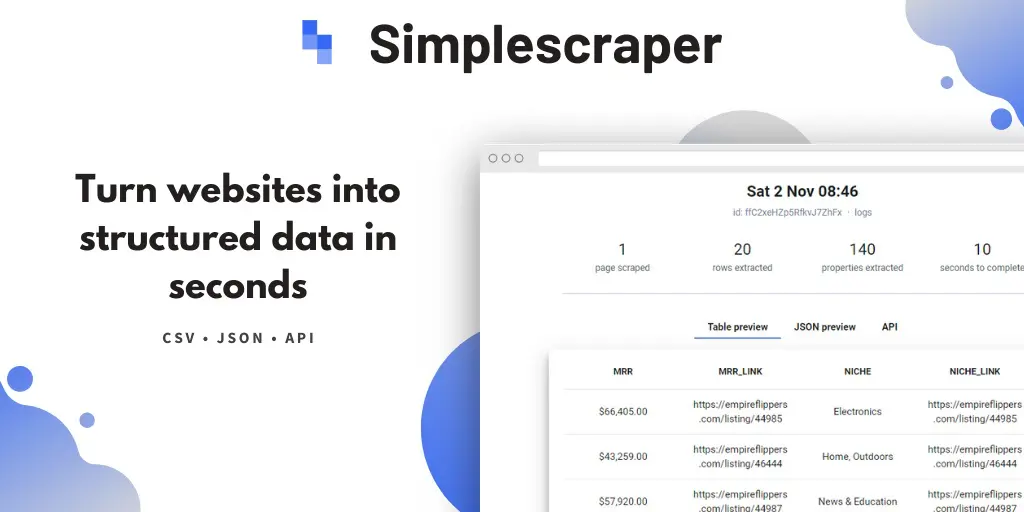

SimpleScraper

- Ценообразование: Бесплатно

- Бесплатные пробные версии: Версия для Chrome полностью бесплатна

- Формат вывода данных: JSON

SimpleScraper — это еще один веб-парсер, доступный в качестве расширения Chrome. С помощью этого расширения, установленного в вашем браузере Chrome, веб-парсинг становится простым и бесплатным, поскольку вы можете превратить любой веб-сайт в API. Это расширение поможет вам очень быстро извлечь структурированные данные из веб-страниц, и оно работает на всех веб-сайтах, включая те, которые содержат JavaScript. Если вам нужен более гибкий вариант, вы можете воспользоваться их облачным решением, но оно платное.

Agenty Scraping Agent

- Ценообразование: Бесплатно

- Бесплатные испытания: 14 дней бесплатной пробной версии — кредит 100 страниц

- Формат вывода данных: Электронная таблица Google, CSV, Excel

- Служба ротации IP

С Agenty Scraping Agent вы можете приступить к парсингу данных с веб-страниц, не задумываясь о блоках. Этот инструмент не является бесплатным, но он предлагает бесплатную пробную версию. Это расширение браузера было разработано для современного Интернета и, как таковое, не имеет проблем с парсингом веб-сайтов, перегруженных JavaScript. Интересно, что оно также отлично работает на старых сайтах.

Прокси-серверы для веб-парсинга

Правда в том, что если вы не используете API для веб-парсинга, который, как правило, считается дорогим, прокси-серверы просто необходимы. Когда речь заходит о прокси для веб-парсинга, я советую пользователям использовать прокси-провайдеров с ротацией IP-адресов по месту жительства — это снимает с вас бремя управления прокси. Ниже приведены 3 лучших сервиса ротации IP на рынке.

Luminati

- Размер IP-пула: Более 72 миллионов

- Местонахождение: Все страны мира

- Допустимый параллелизм: Неограниченно

- Разрешенная пропускная способность: Начиная с 40 ГБ

- Стоимость: от $500 в месяц за 40 ГБ.

Luminati — это, пожалуй, лучший прокси-провайдер на рынке. Он также владеет самой большой прокси-сетью в мире, с более чем 72 миллионами жилых IP-адресов в прокси-пуле Luminati. Она остается одной из самых безопасных, надежных и быстрых. Интересно, что он совместим с большинством популярных веб-сайтов в Интернете. Luminati имеет лучшую систему контроля сессий, поскольку позволяет вам самостоятельно определять время поддержания сессий — он также имеет высокоротируемые прокси, которые меняют IP после каждого запроса. Однако он является дорогим.

Smartproxy

- Размер IP-пула: Более 10 миллионов

- Месторасположение: 195 точек по всему миру

- Допустимый параллелизм: Неограниченно

- Разрешенная пропускная способность: Начиная с 5 ГБ

- Стоимость: от $75 в месяц за 5 ГБ.

Smartproxy владеет пулом жилых прокси с более чем 10 миллионами жилых IP-адресов. Их прокси отлично подходят для веб-парсинга благодаря системе контроля сессий. У них есть прокси, которые могут поддерживать сессию и один и тот же IP в течение 10 минут — это идеально подходит для парсинга веб-сайтов, основанных на логине. Для обычных веб-сайтов вы можете использовать их прокси с высокой ротацией, которые меняют IP после каждого запроса. Они имеют прокси-серверы примерно в 195 странах и в 8 крупных городах по всему миру.

Crawlera

- Размер IP-пула: Не определено — десятки тысяч

- Местонахождение: Few

- Разрешенная пропускная способность: Неограниченно

- Стоимость:начинается от $99 за 200 000 запросов

Crawlera помогает сосредоточиться на данных, помогая вам позаботиться о прокси-серверах. В отличие от Luminati, Crawlera имеет недостаток в количестве IP-адресов в своей системе. Однако, в отличие от Luminati, Crawlera использует некоторые хитрости, чтобы убедиться, что запрошенные вами веб-страницы будут возвращены. Однако у них нет прокси во всех странах и городах мира, как у Luminati. Их цены основаны на количестве запросов, а не на потребляемой пропускной способности.

Услуги веб-парсинга

Бывают случаи, когда вы даже не хотите заниматься парсингом нужных вам данных — все, что вам нужно, это доставленные вам данные. Если вы сейчас находитесь в таком состоянии, то нижеперечисленные услуги веб-парсинга — ваш самый надежный выбор.

Scrapinghub

Scrapinghub стал авторитетом в индустрии веб-парсинга, так как у них есть как бесплатные, так и платные инструменты, предназначенные для использования разработчиками веб-парсеров. Помимо предоставления этих инструментов, у них также есть услуга по предоставлению данных, когда вы только описываете необходимые данные, а они присылают вам предложение. Только этой услугой воспользовались более 2000 компаний.

ScrapeHero

ScrapeHero — еще один поставщик услуг веб-парсинга, к которому можно обратиться за данными, если вы не хотите самостоятельно заниматься их сбором. По сравнению со Scrapinghub, ScrapeHero является более молодой компанией — однако, она довольно популярна среди предпринимателей. От ScrapeHero вы можете получить данные о недвижимости, исследования и журналистику, а также данные из социальных сетей. Вам также необходимо связаться с ними для получения предложения.

Octoparse Сервис по сбору данных

Octoparse известен тем, что предоставляет облачное решение для веб-парсинга, а также приложение для настольных компьютеров. Помимо этих двух решений, Octoparse также предоставляет услуги по парсингу данных для предприятий. С их помощью вы можете получить данные социальных сетей, данные электронной коммерции и розничной торговли, а также объявления о вакансиях и другие данные, которые вы можете найти в Интернете.

PromptCloud

Если вы не хотите возиться с веб-парсерами, прокси-серверами, серверами, взломщиками капчи и API для веб-парсинга, то PromptCloud — это сервис, который стоит выбрать. С ними вам нужно только отправить требуемые данные и ждать, пока они их доставят — довольно быстро, в нужном формате. С их помощью вы получите очищенные данные с веб-страниц без каких-либо технических сложностей. Они предоставляют полностью управляемую услугу с выделенной командой поддержки.

FindDataLab

FindDataLab — поставщик услуг веб-парсинга, который может помочь вам извлечь данные из Интернета, а также помочь в отслеживании цен и управлении репутацией. С помощью их услуги веб-парсинга любой веб-сайт может получить данные в нужном формате. Все, что требуется от вас, это описать необходимые данные, после чего с вами свяжутся и предложат цену.

Заключение

Глядя на список инструментов для веб-парсинга, начиная от инструментов, предназначенных для кодеров и заканчивая инструментами для некодеров, вы согласитесь со мной, что веб-парсинг стал проще. И с таким количеством инструментов, доступных вам, у вас есть хороший выбор, и если некоторые из них не подходят для вашего случая использования, другие подойдут. У вас больше нет причин не делать выводы из данных, поскольку веб-парсинг может помочь вам извлечь их из веб-страниц.

ОБРАЗОВАТЕЛЬНЫЕ УСЛУГИ

База всех компаний в категории: УНИВЕРСИТЕТЫ

ТРАНСПОРТИРОВКА И ХРАНЕНИЕ

База всех компаний в категории: ОКВЭД 52.21.29 — ПРОЧАЯ ВСПОМОГАТЕЛЬНАЯ ДЕЯТЕЛЬНОСТЬ, СВЯЗАННАЯ С АВТОМОБИЛЬНЫМ ТРАНСПОРТОМ

ОПТОВАЯ И РОЗНИЧНАЯ ТОРГОВЛЯ, РЕМОНТ АВТОТРАНСПОРТА

База всех компаний в категории: ОКВЭД 46.37 — ОПТОВАЯ ТОРГОВЛЯ КОФЕ, ЧАЕМ, КАКАО И ПРЯНОСТЯМИ

ЮРИДИЧЕСКИЕ УСЛУГИ

База всех компаний в категории: БРАКОРАЗВОДНЫЕ ДЕЛА

ЦИФРОВЫЕ УСЛУГИ

База всех компаний в категории: ОБЛАЧНЫЕ СЕРВИСЫ

ОПТОВАЯ ТОРГОВЛЯ

База всех компаний в категории: ОПТОВАЯ ПРОДАЖА КОЖИ

WILDBERRIES

WILDBERRIES

ПРОИЗВОДСТВЕННЫЕ УСЛУГИ

База всех компаний в категории: ПРОИЗВОДИТЕЛЬ ТЕКСТИЛЬНОЙ ПРОДУКЦИИ