Подытог: ₽0.00

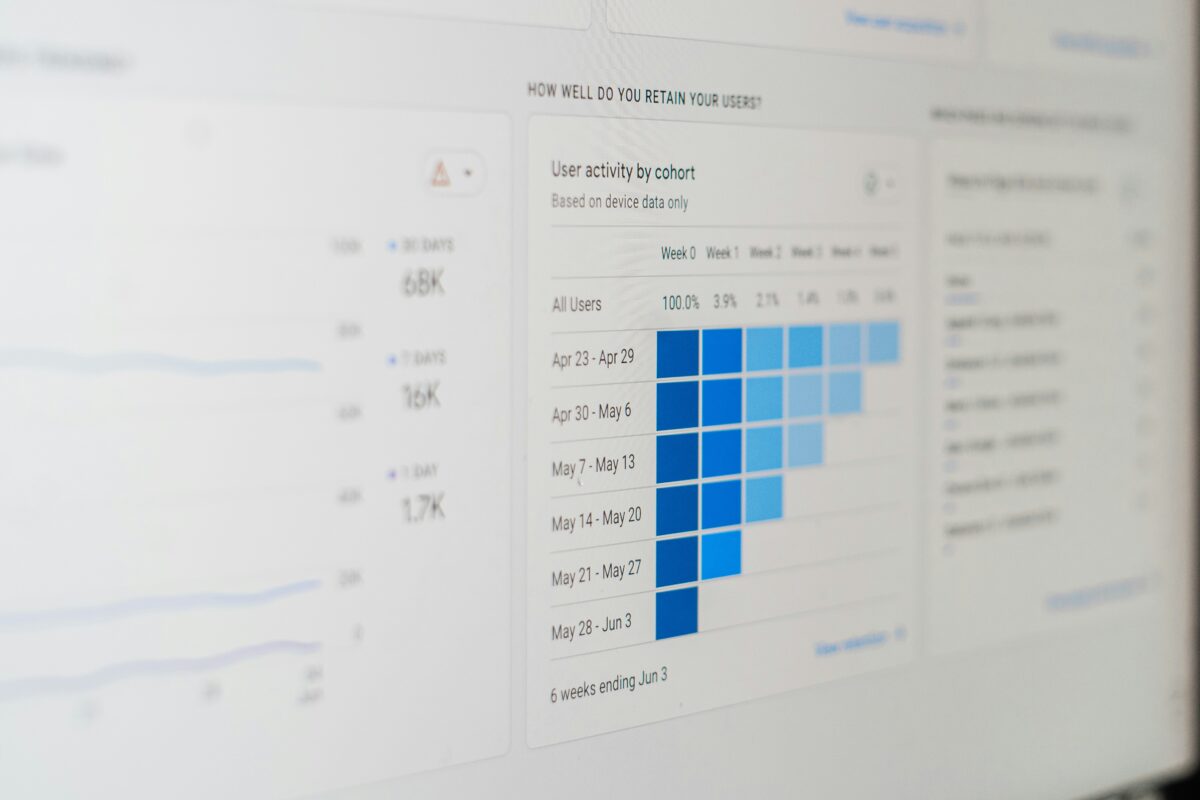

Бизнес-аналитика

Арсенал Аналитика Данных: Путеводитель по Лучшим Инструментам

В современном мире, где данные являются новой нефтью, профессия аналитика данных становится все более востребованной. Аналитики данных играют ключевую роль в преобразовании сырых данных в ценные инсайты, которые помогают компаниям принимать обоснованные решения. Однако, для эффективной работы аналитику необходим надежный набор инструментов. Эта статья представляет собой подробное руководство по лучшим инструментам, которые должен освоить каждый аналитик данных, от начинающего до эксперта. Мы рассмотрим не только сами инструменты, но и приведем примеры их использования, советы и лучшие практики.

Введение: Почему выбор правильных инструментов критически важен?

Работа аналитика данных охватывает широкий спектр задач, включая сбор данных, их очистку и преобразование, анализ, визуализацию и интерпретацию результатов. Каждый из этих этапов требует применения специализированных инструментов. Выбор правильного инструментария может существенно повлиять на эффективность, скорость и качество работы аналитика.

Представьте себе строительство дома. Вы можете попытаться построить его голыми руками, но это займет огромное количество времени и усилий, а результат, скорее всего, будет далек от идеала. Наличие качественных инструментов, таких как молоток, пила, уровень, позволит вам выполнить работу быстрее, качественнее и с меньшими усилиями. Аналогично, владение правильным набором инструментов позволяет аналитику данных решать сложные задачи более эффективно и получать более точные и полезные результаты.

В этой статье мы рассмотрим ключевые категории инструментов для аналитика данных и подробно разберем наиболее популярные и эффективные из них.

1. Языки Программирования: Основа Аналитической Мощи

Языки программирования являются фундаментальным инструментом для любого аналитика данных. Они позволяют автоматизировать рутинные задачи, выполнять сложные аналитические расчеты и разрабатывать собственные аналитические решения. Два языка доминируют в мире аналитики данных: Python и R.

1.1. Python: Универсальность и Богатая Экосистема

Python завоевал популярность благодаря своей простоте, читаемости и мощной экосистеме библиотек для работы с данными.

Ключевые библиотеки Python для аналитики данных:

- Pandas: Библиотека для анализа и обработки структурированных данных. Предоставляет мощные структуры данных, такие как DataFrame, позволяющие эффективно манипулировать табличными данными. (Ссылка на документацию Pandas)

import pandas as pd

# Создание DataFrame из словаря

data = {'col1': [1, 2], 'col2': [3, 4]}

df = pd.DataFrame(data)

print(df)

# Чтение данных из CSV файла

df_csv = pd.read_csv('data.csv')

print(df_csv.head())

# Фильтрация данных

filtered_df = df_csv[df_csv['column_name'] > 10]

print(filtered_df)Совет: Используйте метод .pipe() для создания цепочек обработки данных, что повышает читаемость кода.

- NumPy: Базовая библиотека для научных вычислений. Предоставляет поддержку многомерных массивов и матриц, а также широкий набор математических функций. (Ссылка на документацию NumPy)

import numpy as np

# Создание NumPy массива

arr = np.array([1, 2, 3, 4, 5])

print(arr)

# Выполнение математических операций

mean_value = np.mean(arr)

print(f"Среднее значение: {mean_value}")Лучшая практика: Векторизованные операции NumPy значительно быстрее, чем итерации по элементам массива. Старайтесь использовать их, где это возможно.

- Scikit-learn: Мощная библиотека для машинного обучения. Содержит алгоритмы для классификации, регрессии, кластеризации, понижения размерности и многое другое. (Ссылка на документацию Scikit-learn)

from sklearn.linear_model import LinearRegression

from sklearn.model_selection import train_test_split

import numpy as np

# Пример данных

X = np.array([[1], [2], [3], [4]])

y = np.array([2, 4, 5, 4])

# Разделение данных на обучающую и тестовую выборки

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

# Обучение модели линейной регрессии

model = LinearRegression()

model.fit(X_train, y_train)

# Прогнозирование на тестовых данных

predictions = model.predict(X_test)

print(f"Прогнозы: {predictions}")Совет: Используйте GridSearchCV или RandomizedSearchCV для автоматической настройки гиперпараметров моделей.

- Matplotlib и Seaborn: Библиотеки для визуализации данных. Matplotlib предоставляет низкоуровневый контроль над графиками, а Seaborn строит на его основе более сложные и информативные статистические визуализации. (Ссылка на документацию Matplotlib, Ссылка на документацию Seaborn)

import matplotlib.pyplot as plt

import seaborn as sns

# Линейный график

plt.plot([1, 2, 3, 4], [5, 6, 7, 8])

plt.xlabel("Ось X")

plt.ylabel("Ось Y")

plt.title("Пример линейного графика")

plt.show()

# Диаграмма рассеяния

sns.scatterplot(x=[1, 2, 3, 4], y=[5, 6, 7, 8])

plt.show()Лучшая практика: Всегда подписывайте оси, добавляйте заголовки и легенды для понятности ваших визуализаций.

1.2. R: Статистическая Мощь и Графическая Изысканность

R — это язык программирования и среда разработки, специально созданная для статистических вычислений и графики. Он особенно популярен в академической среде и среди статистиков.

Ключевые пакеты R для аналитики данных:

- dplyr: Пакет для манипулирования данными. Предоставляет интуитивно понятные «глаголы» для фильтрации, сортировки, группировки и преобразования данных. (Ссылка на документацию dplyr)

library(dplyr)

# Создание data frame

df <- data.frame(col1 = c(1, 2), col2 = c(3, 4))

print(df)

# Фильтрация данных

filtered_df <- filter(df, col1 > 1)

print(filtered_df)

# Группировка и агрегация

grouped_df <- df %>%

group_by(col1) %>%

summarise(mean_col2 = mean(col2))

print(grouped_df)Совет: Используйте оператор %>% (пайп) для создания последовательных операций обработки данных.

- tidyr: Пакет для «аккуратной» обработки данных (tidy data). Помогает приводить данные к структуре, где каждая переменная формирует столбец, каждое наблюдение — строку, а каждый тип наблюдаемой единицы — таблицу. (Ссылка на документацию tidyr)

library(tidyr)

# Преобразование "широкого" формата в "длинный"

wide_data <- data.frame(id = 1:2, a_2020 = c(10, 15), a_2021 = c(12, 18))

long_data <- wide_data %>%

pivot_longer(cols = starts_with("a_"), names_to = "year", values_to = "value")

print(long_data)Лучшая практика: Приведение данных к «аккуратному» формату упрощает их анализ и визуализацию.

- ggplot2: Мощный пакет для создания информативных и эстетически привлекательных графиков, основанный на «грамматике графики». (Ссылка на документацию ggplot2)

library(ggplot2)

# Диаграмма рассеяния

ggplot(data = data.frame(x = c(1, 2, 3, 4), y = c(5, 6, 7, 8)), aes(x = x, y = y)) +

geom_point() +

labs(title = "Пример диаграммы рассеяния", x = "Ось X", y = "Ось Y")

# Гистограмма

ggplot(data = data.frame(values = rnorm(100)), aes(x = values)) +

geom_histogram()Совет: Экспериментируйте с различными геометрическими объектами (geom_) и эстетиками (aes()) для создания разнообразных визуализаций.

- caret: Пакет для машинного обучения. Обеспечивает унифицированный интерфейс для обучения и оценки различных моделей машинного обучения. (Ссылка на документацию caret)

library(caret)

# Пример данных

data <- data.frame(feature1 = rnorm(100), feature2 = rnorm(100), target = factor(sample(c("A", "B"), 100, replace = TRUE)))

# Разделение данных

train_index <- createDataPartition(data$target, p = 0.8, list = FALSE)

train_data <- data[train_index, ]

test_data <- data[-train_index, ]

# Обучение модели логистической регрессии

model <- train(target ~ ., data = train_data, method = "glm", family = "binomial")

# Прогнозирование

predictions <- predict(model, newdata = test_data)

print(predictions)Лучшая практика: Используйте кросс-валидацию (trainControl) для более надежной оценки производительности моделей.

Таблица 1: Сравнение Python и R для аналитики данных

| Характеристика | Python | R |

|---|---|---|

| Основное назначение | Универсальный язык программирования | Статистические вычисления и графика |

| Экосистема | Богатая и разнообразная, не только для данных | Специализированная для статистики и анализа |

| Простота изучения | Относительно прост в изучении | Более крутая кривая обучения для новичков |

| Визуализация | Matplotlib, Seaborn, Plotly, Bokeh | ggplot2, base graphics |

| Машинное обучение | Scikit-learn, TensorFlow, PyTorch | caret, mlr3 |

| Интеграция с другими системами | Хорошая | Хорошая |

| Сообщество | Очень большое и активное | Сильное академическое сообщество |

2. Базы Данных и SQL: Управление и Извлечение Данных

Большинство аналитических проектов начинаются с извлечения данных из баз данных. SQL (Structured Query Language) является стандартным языком для взаимодействия с реляционными базами данных. Знание SQL необходимо для написания запросов, позволяющих извлекать, фильтровать, агрегировать и преобразовывать данные.

Основные концепции SQL:

- SELECT: Используется для выбора столбцов, которые нужно извлечь.

- FROM: Указывает таблицу, из которой извлекаются данные.

- WHERE: Фильтрует строки на основе заданного условия.

- GROUP BY: Группирует строки с одинаковыми значениями в указанном столбце.

- HAVING: Фильтрует группы на основе заданного условия (применяется после

GROUP BY). - JOIN: Объединяет данные из нескольких таблиц на основе общего столбца.

-- Выбрать все столбцы из таблицы 'customers'

SELECT * FROM customers;

-- Выбрать столбцы 'name' и 'email' из таблицы 'customers'

SELECT name, email FROM customers;

-- Выбрать клиентов из города 'New York'

SELECT * FROM customers WHERE city = 'New York';

-- Посчитать количество клиентов в каждом городе

SELECT city, COUNT(*) FROM customers GROUP BY city;

-- Выбрать города, где количество клиентов больше 10

SELECT city, COUNT(*) FROM customers GROUP BY city HAVING COUNT(*) > 10;

-- Объединить таблицы 'orders' и 'customers' по столбцу 'customer_id'

SELECT orders.*, customers.name

FROM orders

JOIN customers ON orders.customer_id = customers.id;- Используйте

EXPLAINдля анализа планов выполнения запросов: Это поможет выявить узкие места и оптимизировать запросы. - Индексируйте часто используемые столбцы для фильтрации и объединений: Индексы значительно ускоряют поиск данных.

- Пишите читаемые запросы: Используйте отступы и комментарии для улучшения понимания кода.

- Избегайте

SELECT *в производственных системах: Выбирайте только необходимые столбцы для уменьшения объема передаваемых данных.

Популярные СУБД (системы управления базами данных):

- MySQL: Популярная реляционная СУБД с открытым исходным кодом. (Ссылка на документацию MySQL)

- PostgreSQL: Мощная реляционная СУБД с открытым исходным кодом, известная своей надежностью и расширяемостью. (Ссылка на документацию PostgreSQL)

- Microsoft SQL Server: Коммерческая реляционная СУБД от Microsoft. (Ссылка на документацию SQL Server)

- SQLite: Легковесная встраиваемая СУБД. (Ссылка на документацию SQLite)

3. Инструменты Визуализации Данных: Превращение Инсайтов в Истории

Визуализация данных играет ключевую роль в процессе анализа. Хорошо подобранные визуализации помогают аналитикам выявлять закономерности, тренды и аномалии в данных, а также эффективно доносить свои выводы до заинтересованных сторон.

Популярные инструменты визуализации данных:

- Tableau: Мощная и интуитивно понятная платформа для визуализации и анализа данных. Позволяет создавать интерактивные дашборды и отчеты без необходимости написания кода. (Ссылка на сайт Tableau) Совет: Используйте «рассказы» (stories) в Tableau для последовательного представления ваших аналитических выводов.

- Power BI: Инструмент бизнес-аналитики от Microsoft, предоставляющий возможности визуализации, интерактивных дашбордов и отчетов. Хорошо интегрируется с другими продуктами Microsoft. (Ссылка на сайт Power BI) Лучшая практика: Оптимизируйте модели данных Power BI для повышения производительности дашбордов.

- Google Data Studio (Looker Studio): Бесплатный инструмент для визуализации данных от Google. Интегрируется с различными источниками данных Google, такими как Google Analytics и Google Sheets. (Ссылка на сайт Looker Studio) Совет: Используйте параметры в Google Data Studio для создания более гибких и интерактивных отчетов.

- Python библиотеки (Matplotlib, Seaborn, Plotly, Bokeh): Как уже упоминалось, Python предоставляет мощные библиотеки для создания различных типов визуализаций. Plotly и Bokeh позволяют создавать интерактивные веб-ориентированные графики. (Ссылка на документацию Plotly, Ссылка на документацию Bokeh)

Лучшие практики визуализации данных:

- Выберите правильный тип графика для ваших данных и сообщения: Например, гистограммы для распределения, диаграммы рассеяния для взаимосвязей, линейные графики для трендов.

- Сохраняйте простоту и ясность: Избегайте перегруженности информацией.

- Используйте цвет эффективно: Цвет должен подчеркивать важные аспекты данных, а не отвлекать.

- Добавляйте подписи, заголовки и легенды: Обеспечьте понимание ваших визуализаций без дополнительных объяснений.

4. Облачные Платформы для Аналитики Данных: Масштабируемость и Гибкость

Облачные платформы предоставляют широкий спектр сервисов для хранения, обработки и анализа больших объемов данных. Они предлагают масштабируемость, гибкость и экономическую эффективность.

Основные облачные платформы:

- Amazon Web Services (AWS): Лидирующая облачная платформа с широким набором сервисов для хранения данных (S3), обработки (EC2, EMR, Lambda), баз данных (RDS, DynamoDB), аналитики (Athena, Redshift) и машинного обучения (SageMaker). (Ссылка на сайт AWS)

- Microsoft Azure: Вторая по величине облачная платформа, предлагающая аналогичные сервисы для хранения (Blob Storage), обработки (Virtual Machines, Azure Databricks, Azure Functions), баз данных (SQL Database, Cosmos DB), аналитики (Synapse Analytics) и машинного обучения (Azure Machine Learning). (Ссылка на сайт Azure)

- Google Cloud Platform (GCP): Быстрорастущая облачная платформа с сильным фокусом на анализе данных и машинном обучении. Предлагает сервисы для хранения (Cloud Storage), обработки (Compute Engine, Dataflow, Cloud Functions), баз данных (Cloud SQL, Cloud Spanner, Bigtable), аналитики (BigQuery) и машинного обучения (Vertex AI). (Ссылка на сайт GCP)

Ключевые облачные сервисы для аналитики данных:

- Объектное хранилище (AWS S3, Azure Blob Storage, Google Cloud Storage): Для хранения больших объемов неструктурированных данных.

- Сервисы обработки данных (AWS EC2, Azure Virtual Machines, Google Compute Engine): Виртуальные машины для запуска аналитических приложений.

- Управляемые кластеры Hadoop и Spark (AWS EMR, Azure HDInsight, Google Cloud Dataproc): Для обработки больших данных с использованием фреймворков Hadoop и Spark.

- Бессерверные вычисления (AWS Lambda, Azure Functions, Google Cloud Functions): Для выполнения кода без управления серверами.

- Облачные хранилища данных (AWS Redshift, Azure Synapse Analytics, Google BigQuery): Оптимизированные для аналитических запросов хранилища данных.

- Сервисы машинного обучения (AWS SageMaker, Azure Machine Learning, Google Vertex AI): Для обучения и развертывания моделей машинного обучения.

5. Инструменты для Работы с Большими Данными: Обработка Масштаба

Когда объемы данных становятся слишком большими для обработки на одном компьютере, на помощь приходят инструменты для работы с большими данными.

- Apache Hadoop: Фреймворк для распределенной обработки больших наборов данных на кластерах компьютеров. Включает в себя Hadoop Distributed File System (HDFS) для хранения данных и MapReduce для обработки. (Ссылка на сайт Apache Hadoop)

- Apache Spark: Фреймворк для быстрой обработки больших данных. Работает в памяти, что значительно ускоряет выполнение аналитических задач по сравнению с Hadoop MapReduce. Поддерживает различные языки программирования, включая Python (PySpark), Scala, Java и R. (Ссылка на сайт Apache Spark)

from pyspark.sql import SparkSession

# Создание SparkSession

spark = SparkSession.builder.appName("BigDataAnalysis").getOrCreate()

# Чтение данных из файла

df = spark.read.csv("large_data.csv", header=True, inferSchema=True)

# Выполнение анализа

average_value = df.agg({"column_name": "avg"}).collect()[0][0]

print(f"Среднее значение: {average_value}")

# Остановка SparkSession

spark.stop()Совет: Оптимизируйте Spark приложения, используя паркетированные файлы и избегая перемешивания данных, где это возможно.

- Apache Kafka: Распределенная платформа потоковой передачи данных. Позволяет создавать конвейеры данных в реальном времени. (Ссылка на сайт Apache Kafka)

- Apache Flink: Еще один мощный фреймворк для потоковой обработки данных. Обеспечивает обработку событий в реальном времени с высокой пропускной способностью и низкой задержкой. (Ссылка на сайт Apache Flink)

6. Другие Важные Инструменты:

- Jupyter Notebook/Lab: Интерактивные среды разработки, позволяющие объединять код, текст, визуализации и мультимедиа в одном документе. Идеально подходят для исследования данных, прототипирования и создания отчетов. (Ссылка на проект Jupyter)

- Git: Система контроля версий, необходимая для совместной работы над проектами и отслеживания изменений в коде. (Ссылка на сайт Git)

- Инструменты ETL (Extract, Transform, Load): Для автоматизации процесса извлечения данных из различных источников, их преобразования и загрузки в целевое хранилище. Примеры: Apache NiFi, Informatica PowerCenter, Talend.

Заключение: Постоянное Развитие и Адаптация

Выбор правильных инструментов — это непрерывный процесс, который зависит от конкретных задач, доступных ресурсов и личных предпочтений. В этой статье мы рассмотрели лишь основные инструменты, доступные аналитику данных. Технологии постоянно развиваются, и появляются новые инструменты и подходы. Поэтому важно оставаться в курсе последних тенденций и постоянно расширять свой инструментарий.

Станьте мастером своего ремесла, изучая и применяя эти мощные инструменты. Помните, что владение инструментами — это только часть успеха. Критическое мышление, умение задавать правильные вопросы и эффективно интерпретировать результаты играют не менее важную роль в работе аналитика данных.

Список источников для подготовки материала:

- Официальная документация библиотек и инструментов: Ссылки на документацию были приведены в соответствующих разделах статьи.

- Курсы и учебные материалы по аналитике данных: Coursera, Udacity, edX, DataCamp, Kaggle Learn.

- Блоги и статьи по аналитике данных: Towards Data Science, Analytics Vidhya, KDnuggets.

- Книги по анализу данных и машинному обучению.

- Форумы и сообщества аналитиков данных: Stack Overflow, Reddit (r/datascience, r/learnpython, r/rstats).

Вопросы для проверки усвоения материала:

- Назовите как минимум три ключевые библиотеки Python, используемые в анализе данных, и кратко опишите их назначение.

- В чем основные различия между языками программирования Python и R в контексте аналитики данных?

- Опишите основные операции SQL, необходимые для извлечения и фильтрации данных из базы данных.

- Какие типы визуализаций данных вы знаете и для каких целей они обычно используются?

- Перечислите три основные облачные платформы, предоставляющие сервисы для аналитики данных, и назовите по одному ключевому сервису для хранения и обработки данных на каждой из них.

- В чем преимущества использования инструментов для работы с большими данными, таких как Apache Spark?

- Для каких целей используется Jupyter Notebook в работе аналитика данных?

- Объясните, почему система контроля версий Git важна для командной работы над аналитическими проектами.

- Приведите пример, когда использование инструмента ETL будет полезно в процессе анализа данных.

- Как вы считаете, какие навыки и знания, помимо владения инструментами, необходимы успешному аналитику данных?

- (Изображение) Логотипы Python, R, SQL, Tableau, Power BI, AWS, Azure, GCP на одном изображении с подписью «Основные инструменты аналитика данных».

- (Изображение) Схематичное изображение пайплайна обработки данных, демонстрирующее последовательность использования различных инструментов (сбор данных -> SQL -> Python/R -> Визуализация).

ОЗОН.РУ

ОЗОН.РУ

![13 лучших инструментов для восстановления данных iPhone и iPad - [Восстановление данных]](https://xmldatafeed.com/wp-content/uploads/2023/03/preview-18-120x120.jpg)

МЕДИЦИНСКИЕ УСЛУГИ

База всех компаний в категории: КРИЗИСНЫЕ ЦЕНТРЫ

МЕДИЦИНСКИЕ УСЛУГИ

База всех компаний в категории: ЛАБОРАТОРИЯ

УСЛУГИ ДОМАШНЕГО МАСТЕРА

База всех компаний в категории: ПОРТНОЙ

АВТОМОБИЛЬНЫЕ УСЛУГИ

База всех компаний в категории: ДИЛЕР NISSAN

ПРОИЗВОДСТВЕННЫЕ УСЛУГИ

База всех компаний в категории: АВТОМОБИЛЬНЫЕ ОТОПИТЕЛИ

РЕКЛАМНЫЕ УСЛУГИ

База всех компаний в категории: ШЕЛКОГРАФИЯ

ПАРИКМАХЕРСКИЕ И САЛОНЫ КРАСОТЫ

База всех компаний в категории: СПА САЛОНЫ УСЛУГИ

ИСКУССТВО И КУЛЬТУРА

База всех компаний в категории: ФОТОЦЕНТРЫ